L’algorithme de Google est l’objet de nombreuses interrogations, et c’est bien normal ! C’est lui (ou plutôt eux, car nous verrons qu’il y a en réalité plusieurs algorithmes) qui garantit aux sites web une bonne place dans leimis résultats de recherche… ou pas.

Pour bien optimiser votre site, il est donc impératif de comprendre comment fonctionne l’algorithme de Google.

Bien entendu, un algorithme n’est jamais gravé dans le marbre. Il évolue au rythme des changements de comportement des internautes et des améliorations apportées par Google.

C’est pourquoi vous trouverez aussi dans cet article les 10 mises à jour principales de l’algorithme de Google à connaître pour améliorer votre référencement.

Avant de débuter votre lecture, si vous souhaitez améliorer le SEO de votre boutique en ligne, téléchargez gratuitement notre livre blanc seo.

SOMMAIRE :

Comment fonctionne l’algorithme de Google ?

Algorithme : définition et explications

Ah… L’algorithmie ! Sur le Web, tout le monde en parle. Pourtant, rares sont ceux qui peuvent en donner une définition précise. C’est donc ce que nous allons tâcher de faire pour commencer.

En effet, il sera plus facile de décrire le fonctionnement des algorithmes de Google lorsque nous saurons avec précision ce qu’est un algorithme.

Le dictionnaire Larousse en donne la définition suivante : « Ensemble de règles opératoires dont l’application permet de résoudre un problème énoncé au moyen d’un nombre fini d’opérations. »

Pour faire simple, un algorithme ce sont des règles très précises (dans le cas de Google, des règles informatiques), qui permettent de systématiser une opération ou une fonction. Il s’agit donc d’une procédure codifiée pour obtenir un résultat, comme :

- trouver une information à partir d’un mot-clé ;

- faire un calcul ;

- placer un point sur une carte ;

- classer des résultats selon un ordre de pertinence…

Bref, avec un algorithme bien construit, on peut tout faire !

Google : plusieurs algorithmes qui fonctionnent de concert

Lorsque vous cherchez une information sur Google, vous obtenez en un quart de seconde des centaines de résultats qui s’affichent dans un ordre précis : du plus pertinent au moins pertinent.

Pour réussir cette prouesse, Google n’a pas misé sur un seul, mais sur plusieurs algorithmes très puissants. Ils ont tous une fonction spécifique et travaillent ensemble, comme une équipe.

Ils permettent entre autres de systématiser les opérations suivantes :

- le crawl : la découverte des pages ;

- l’indexation : l’enregistrement des sites dans le répertoire de Google ;

- la compréhension des requêtes : pour la pertinence des résultats de recherche ;

- ou encore le classement des sites et les filtres (ranking).

Il faut savoir que les algorithmes de Google ont pour vocation de répondre au mieux aux attentes des internautes.

En bref, plus votre site correspond à ce que cherchent les internautes, plus il plaît à l’algorithme de Google et mieux il se classe dans les pages de résultats.

CQFD !

Comprendre le fonctionnement de « l’algo » de Google et ses évolutions est donc indispensable pour votre SEO.

Les modifications d’algorithmes : une spécialité de Google

1, 2, 3… 1, 2, 3… Quand la Google Dance faisait valser l’index

Un algorithme n’est pas une opération figée. Il évolue pour suivre du mieux possible les changements de comportement des internautes.

Au début des années 2000, Google mettait à jour son index au rythme de la Google Dance. Cette « valse » de l’indexation (pour rester dans la métaphore musicale) avait lieu tous les mois.

Tous les 30 jours environ, le moteur de recherche supprimait son index pour le remplacer par un nouveau constitué des pages explorées par ses robots au cours du mois écoulé.

Autant dire que les propriétaires de sites internet et les webmasters redoutaient ces modifications mensuelles.

La musique s’est arrêtée en 2003. La Google Dance a pris fin.

L’avènement des filtres algorithmiques

Pour nettoyer son index et garantir des résultats de recherche aussi pertinents que possible, Google a mis en place des filtres algorithmiques. Derrière leurs petits noms animaliers (Panda, Pingouin… pour citer les plus connus) ces filtres cachent une efficacité redoutable.

Ils ont pour mission de nettoyer les résultats de Google des spams, des backlinks abusifs et des contenus de faible qualité. Ces filtres étaient lancés à échéance régulière pour faire un grand ménage sur la Toile.

À titre d’information, Pingouin a été lancé 7 fois entre avril 2012 et septembre 2016. Panda, quant à lui, a connu 29 lancements entre février 2011 et juillet 2015.

À chaque lancement de filtre, les impacts sur l’indexation des sites web étaient énormes. Certains sites considérés comme « de mauvaise qualité » pouvaient perdre tout leur trafic organique du jour au lendemain.

Bienvenue à l’ère de l’amélioration continue

Désormais, les mises à jour de l’index se font en continu et les filtres sont intégrés directement aux algorithmes. Ainsi, les changements dans l’indexation des sites sont beaucoup moins brutaux. Ils sont même quasiment imperceptibles tant les mises à jour peuvent être subtiles.

D’autre part, Google travaille chaque jour à l’amélioration de son algorithme afin de rester le moteur de recherche numéro 1 au monde.

En 2016 par exemple, il a procédé à 9 800 tests ayant conduit à 1 653 changements de son algorithme. Deux ans plus tard, Google a annoncé 654 680 tests pour 3 234 modifications de son algo.

Selon les derniers chiffres, qui datent de 2019, 464 065 tests ont été réalisés et l’algorithme a subi 3 620 améliorations.

Cela représente près de 10 modifications chaque jour !

Les 10 mises à jour majeures de l’algorithme de Google

Comme nous l’avons vu, les modifications d’algorithme sont monnaie courante chez Google. Lorsqu’une update est un peu plus virulente que les autres, on parle de mise à jour majeure. Celle-ci est souvent affublée d’un petit nom et fait couler beaucoup d’encre au sein de la communauté SEO.

Dans cette partie, nous allons détailler les mises à jour de l’algorithme qui ont fortement chamboulé les pratiques de référencement pour les propriétaires de sites internet.

Bien entendu, Google a lancé bien plus que 10 mises à jour importantes, mais concentrons-nous uniquement sur celles qu’il faut connaître pour votre SEO.

Vous êtes prêt ? Allons-y !

1. Panda : la mise à jour qui fait la chasse aux mauvais contenus

Comme nous l’avons dit un peu plus haut, cette mise à jour correspond à un filtre algorithmique. Son but ? Différencier le contenu web de bonne qualité et celui de mauvaise qualité.

Panda a été lancé pour la première fois le 24 février 2011 aux États-Unis avant d’être déployé dans le reste du monde quelques mois plus tard.

Son impact a été majeur sur le référencement de nombreux sites. Ceux considérés comme de mauvaise qualité ont été déclassés, au profit de sites dont le contenu était jugé meilleur.

Désormais, il n’est plus lancé à date déterminée, mais fait partie intégrante de l’algo de Google. Il fonctionne en continu. Panda « tout court » est devenu Panda Everflux.

Ce filtre fonctionne sur le principe du machine learning. Autrement dit, l’algorithme apprend tout seul à distinguer les bons des mauvais contenus et, le cas échéant, à appliquer des pénalités. Tout est entièrement automatisé.

Mais, qu’est-ce qu’un « mauvais contenu » pour le Panda de Google ?

Cette mise à jour de l’algorithme vise à déclasser :

- les fermes de contenu : des sites sans valeur ajoutée qui proposent des contenus de piètre qualité sur des requêtes très demandées afin de générer des clics ;

- les mauvais annuaires et les sites qui agrègent des contenus récoltés un peu partout sur le Web (petites annonces, sites qui répertorient les offres promotionnelles, les coupons, etc.) et les comparateurs de prix ;

- les forums, notamment ceux qui ne fournissent pas de réponse aux questions qui y sont posées ;

- les sites proposant du contenu dupliqué (duplicate content) ;

- ou encore les sites sur optimisés (bourrage de mots-clés)…

Pour que votre site ne soit pas impacté par Google Panda, vous pouvez appliquer les bonnes pratiques recommandées par Google et bien entendu, vous pouvez vous référer aux conseils SEO que je donne sur ce blog.

2. Pingouin (Penguin en VO) veut débarrasser le Web des liens de mauvaise qualité

Autre mise à jour majeure qui correspond à un filtre de l’algorithme de Google : Penguin (ou Pingouin pour les francophiles).

Ce petit animal-là a un objectif bien précis : punir les sites qui ont recours à un netlinking abusif. En d’autres termes, ceux qui obtiennent des backlinks de faible qualité et non-pertinents.

Penguin avait également pour mission de lutter contre le spamdexing (spam de contenus) et la suroptimisation. Mais, dans les faits, comme Panda s’occupe déjà des contenus de mauvaise qualité, il y a double emploi.

Au final, c’est donc sur les sites ayant recours aux techniques de netlinking douteuses que les effets de Penguin se font le plus sentir. Parmi les méthodes pénalisées, on retrouve par exemple :

- les achats de liens ;

- les inscriptions en masse à des annuaires ;

- les fermes de liens…

Bien entendu, la suroptimisation des ancres (texte cliquable des liens) est également dans le viseur du volatile de Google.

Pour éviter le coup de bec, mieux vaut donc avoir des liens de qualité plutôt que des liens en quantité ! Si jamais vous remarquez trop de liens faibles pointant vers votre site, n’hésitez pas à les désavouer.

3. BERT : améliorer la pertinence des résultats en levant l’ambiguïté des recherches

Cette mise à jour de l’algorithme de recherche de Google, qui a vu le jour en 2019, vise à mieux comprendre le contexte des requêtes. Ainsi, il permet de fournir des résultats toujours plus pertinents.

BERT signifie Bidirectional Encoder Representations from Transformers ; un terme quelque peu obscur…

Disons que BERT est une update de l’algorithme permettant à Google d’améliorer sa compréhension de l’intention des internautes. Pour cela, il se base sur un système de Natural Language Processing qui lui permet d’interpréter le contexte d’une recherche.

Imaginons que vous tapiez la requête : meilleur avocat pour faire du guacamole. De quel avocat s’agit-il ? Le fruit ou le professionnel ? Pour vous c’est évident, mais avant BERT, cette requête n’était pas facile à interpréter pour Google.

Pour savoir de quel avocat il est question, Google BERT va analyser le champ sémantique autour du mot avocat.

S’il y trouve des mots comme guacamole, mûr, noyau, marché… il en déduira qu’il s’agit du fruit. En revanche, s’il rencontre les termes : procès, tribunal, honoraires… il saura que l’on parle de la profession.

Pour répondre aux exigences de Google BERT et faire ressortir votre site sur des requêtes pertinentes avec votre secteur, il faut donc optimiser vos contenus en enrichissant leur champ sémantique.

4. Hummingbird (ou Colibri) : pour mieux décrypter les demandes des internautes

Un colibri, ça n’a l’air de rien. Et pourtant, ce petit oiseau, qui est venu se nicher sur l’algorithme de Google en 2013, a eu un impact retentissant !

Avec cette mise à jour, le moteur a voulu booster la précision de ses résultats de recherche en améliorant sa compréhension des requêtes des internautes (leur réelle intention de recherche).

Hummingbird permet de décrypter le sens qui se cache derrière les mots tapés dans la barre de recherche. Ainsi, si vous entrez : bon resto près de chez moi, Google sera capable de vous proposer des résultats pertinents. Pourtant, dans votre requête, il n’y a ni le mot restaurant, ni le nom de votre ville !

Ce ne sont donc pas les mots tapés dans la requête qui sont importants, mais votre intention.

Grâce à Hummingbird, Google est capable de comprendre que resto signifie restaurant et que près de chez moi se réfère à l’endroit où vous êtes généralement localisé.

Il est fort ce Colibri, vous ne trouvez pas ?

5. Mobile First : les mobinautes d’abord !

Avec Mobile First, c’est l’algorithme d’indexation de Google qui a été mis à jour, avec pour objectif de s’adapter aux nouveaux comportements des internautes.

En effet, pendant longtemps, c’est la navigation sur ordinateur (desktop) qui avait pignon sur rue. Mais, avec l’avènement des smartphones, c’est maintenant la navigation sur mobile qui est reine.

Google a donc dû s’adapter pour proposer aux internautes (ou plutôt aux mobinautes) des sites mobile friendly, facilement consultables sur smartphone.

Par défaut, Google enregistre désormais tous les sites dans son index mobile, qui est devenu l’index principal, au détriment de l’index desktop.

Pour satisfaire aux exigences de Mobile First, il faut donc vous assurer que votre site soit responsive (adapté à la navigation mobile), au risque de perdre des places dans les pages de résultats de Google.

6. RankBrain : l’update qui ne manque pas de matière grise

Cette mise à jour de l’algorithme de Google s’inscrit dans la continuité de Hummingbird. RankBrain fait appel à l’intelligence artificielle dans le but d’améliorer la pertinence du moteur de recherche.

Depuis 2015, ce nouveau « cerveau » greffé sur l’algorithme de Google permet de comprendre l’intention de recherche des internautes.

Quelle différence avec Colibri, me direz-vous ?

Et bien, là où Colibri arrive à décrypter les différents termes de la requête, RankBrain va interpréter cette dernière comme un tout. Et c’est à cet ensemble de mots qu’il va attribuer une intention.

Ainsi impacte-t-il plus largement les requêtes dites de longue traîne, puisque ce sont elles qui sont les plus complexes à interpréter.

Ce qui est fascinant avec RankBrain c’est que, grâce au machine learning, il est capable d’apprendre de ses propres observations et de s’améliorer tout seul. Au fil du temps, il est donc de plus en plus intelligent et propose des résultats toujours plus précis.

Pour « faire plaisir » à RankBrain, il faut lui donner des informations exploitables afin qu’il puisse apprendre toujours plus. Des contenus exhaustifs et riches sur le plan sémantique devront donc faire partie intégrante de votre stratégie SEO pour que votre site « ranke » (se positionne) bien.

7. Pigeon : l’oiseau spécialiste de la recherche locale

Visiblement, chez Google, on aime bien les oiseaux : après Pingouin et Colibri, il est temps d’évoquer Pigeon.

Cette mise à jour de 2014 (pour les États-Unis, et 2015 en France) concerne principalement les résultats de recherche locale.

Pour faire simple : avec Pigeon, les sites qui optimisent correctement leurs pages pour la géolocalisation sont plus facilement mis en avant dans les résultats de recherche. En revanche, les sites moins précis dans leur géolocalisation sont relégués au second plan.

À savoir : lorsque le Pigeon de Google a commencé à planer au-dessus du Web, 53 % des entreprises et experts du SEO local ont constaté un impact négatif sur leur référencement.

Beaucoup de sites ont donc été contraints de revoir leur stratégie pour améliorer leurs méthodes de géolocalisation.

8. Fred traque les sites internet bourrés de publicités

Ne vous fiez pas à son surnom d’apparence sympathique. Google Fred est en réalité une update redoutable qui a débarqué en 2017. Dans sa ligne de mire ? Les sites surchargés en publicités et liens affiliés.

Généralement, ceux-ci sont peu agréables pour les utilisateurs, gênés par l’excès d’encarts publicitaires. De plus, leur contenu est souvent d’une qualité médiocre.

Dans la continuité de ce qui avait déjà été lancé avec Pingouin, Fred fait donc la chasse à ces sites web qui oublient leur fonction première : répondre aux attentes des utilisateurs. Et, lorsqu’il en trouve un, la sanction tombe ! Le site en question subit une pénalité et se retrouve déclassé dans les résultats de recherche.

Pour éviter de subir les foudres de Fred, je vous conseille vivement de ne pas trop en faire avec la publicité (AdSense, encarts Amazon…). Restez toujours dans l’optique de faciliter la navigation de vos visiteurs sans nuire à leur expérience sur votre site.

9. Medic vaccine le Web contre les contenus peu fiables

En 2018, certains propriétaires de sites web ont constaté d’importantes fluctuations dans leur classement Google. Visiblement, ces bouleversements étaient liés à une mise à jour majeure qui a été dénommée Medic.

Pourquoi Medic ?

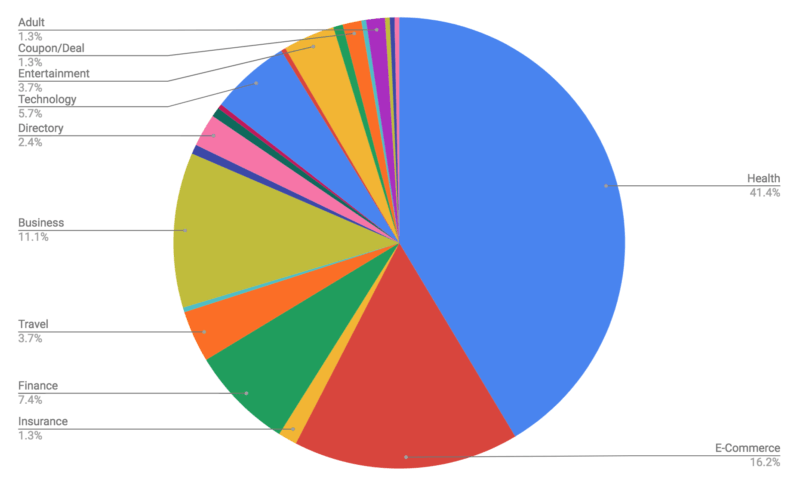

Car il semblerait que les sites à orientation médicale (conseils de santé) ont été les plus touchés. Mais ils n’ont pas été les seuls ! Comme le montre le graphique ci-dessous, beaucoup d’e-commerces ou de sites liés au domaine des finances ont également eu du mal à avaler la pilule Google Medic.

Ces sites ont subi des pénalités, car ils ne répondaient pas suffisamment aux exigences E-A-T (Expertise, Authoritativeness, Trustworthiness ou Expertise, Autorité, Confiance en français) de Google.

Autrement dit, Medic a pénalisé ces sites parce que :

- la qualité de leur contenu laissait à désirer ;

- ils ne faisaient pas autorité dans leur domaine (backlinks de faible qualité) ;

- et, de fait, ils n’étaient pas considérés comme des sources d’information dignes de confiance.

Pour résumer, si vous apportez à vos visiteurs des informations précises et provenant de sources fiables, que vous misez sur la pertinence de vos contenus et travaillez votre netlinking, vous n’aurez pas grand chose à craindre de Google Medic.

10. EMD : les noms de domaine passés au crible de l’algorithme de Google

La dernière mise à jour de l’algo de Google que nous allons décrypter dans cet article concerne un point que l’on oublie souvent : le nom de domaine d’un site.

EMD signifie Exact Match Domain. Cela veut dire que l’algorithme cible les sites dont le nom de domaine correspond pour tout ou partie à la requête sur laquelle ils souhaitent se positionner.

Par exemple : vous êtes agent immobilier à Nîmes et vous donnez à votre site le nom de domaine agent-immobilier-nimes.fr, c’est un EMD.

Il y a encore une dizaine d’années, avoir un EMD garantissait d’être bien positionné dans les résultats de Google, même avec un contenu pauvre. Mais cette époque est révolue !

Avec l’arrivée de la mise à jour Google EMD en 2012, le nom de domaine n’est plus un facteur SEO fort, et c’est désormais le contenu du site qui prime.

L’algorithme de Google est tellement riche et mouvant qu’il est difficile d’en saisir toutes les subtilités. Toutefois, il y a une constante importante : si vous optimisez votre site en pensant à ce que veulent vos visiteurs, vous avez toutes les chances de faire également plaisir aux algorithmes !

Les différentes mises à jour de l’algo le montrent : sur Internet, le contenu est roi. Vous pouvez donc améliorer votre référencement sans (trop) faire de technique. Pour cela, concentrez-vous sur la qualité de vos pages.

Vous voulez savoir comment faire ? Vous trouverez les réponses dans mon livre blanc SEO à télécharger gratuitement.

Passionné d’e-commerce et de SEO, je suis le créateur du site reussir-mon-ecommerce.fr. Depuis plus de 15 années, j’aide les e-commerçants à développer sainement leur entreprise. Et si je ne suis pas devant mon écran, c’est que je suis derrière ma batterie à jouer du rock ! !