L’indexation Google soulève bon nombre de questions auprès des propriétaires de sites internet : de quoi s’agit-il, comment ça fonctionne, comment savoir si mon site est bien indexé ?…

Je vous propose donc de répondre aux 5 questions les plus courantes sur la manière dont Google indexe les sites web.

Nous allons voir en détail quel est le travail des robots de crawl de Google (les fameux Googlebots), mais pas que !

Je vais également vous indiquer quelles sont les meilleures méthodes pour indexer rapidement votre site, pour vérifier l’état de votre indexation, et même pour empêcher l’indexation de vos pages.

C’est tout ?

Non ! En bonus, vous trouverez également une FAQ pour approfondir le sujet.

Avant de débuter votre lecture, si vous souhaitez améliorer le SEO de votre boutique en ligne, téléchargez gratuitement notre livre blanc seo.

SOMMAIRE :

- Définition indexation

- 1. Comment Google indexe-t-il les sites ?

- 2. Pourquoi l’indexation Google est importante pour moi ?

- 3. Comment indexer son site sur Google ?

- 4. Comment savoir si mon site est indexé sur Google ?

- 5. Comment empêcher l’indexation Google ?

- FAQ

Définition indexation

Pour comprendre les mécanismes cachés derrière l’indexation de Google, il faut déjà savoir de quoi il s’agit.

L’indexation Google est un processus au cours duquel Google, par le biais de ses robots, va découvrir vos pages pour les ajouter à son index.

En clair : Google enregistre les pages de votre site dans son répertoire.

Une fois votre site répertorié dans la base de données de Google, celui-ci pourra être trouvé par les internautes.

Maintenant que les bases sont posées, voyons comment fonctionne l’indexation Google et comment indexer votre site.

1. Comment Google indexe-t-il les sites ?

Robots d’indexation

Avant de pouvoir ajouter vos pages à son répertoire, Google a besoin de les découvrir. Il confie cette phase de découverte à de petits « robots » appelés Googlebots.

Vous l’aurez compris, un Googlebot, ce n’est pas un vrai robot façon Terminator (ou Wall-E si vous préférez les gentils robots 🤖). C’est en fait un logiciel qui a pour fonction de repérer et d’analyser tout ce qui existe sur Internet.

Il reconnaît les pages des sites bien entendu, mais aussi :

- leur contenu (éléments textuels, mots-clés, titres, etc.) ;

- les images (via leur attribut ALT) ;

- les URL ;

- les liens qui constituent le maillage interne et externe d’un site ;

- les vidéos…

Les données récupérées par les Googlebots lors de l’exploration des pages sont ensuite envoyées vers les data centers de Google pour y être répertoriées (indexées).

Budget Crawl

Ce processus de découverte et d’indexation des pages est appelé crawl.

Le crawl est extrêmement coûteux pour Google. Aussi, il n’autorise ses robots qu’à passer un temps limité sur chaque site. C’est ce que l’on appelle le budget crawl.

Pendant ce temps alloué, le Googlebot va explorer votre site en suivant les liens qui vont l’emmener de page en page. Pour qu’il puisse en indexer un maximum et envoyer ces informations vers les data centers, il faut donc lui faciliter la tâche.

Les data centers contiennent les serveurs utilisés par Google pour sauvegarder toutes les informations transmises par ses robots.

Google reste très discret sur le nombre de serveurs dont il dispose. Une estimation de 2008 basée sur la surface des data centers annonçait un chiffre de 2 millions de serveurs. Bien entendu, cela n’a jamais été confirmé par le géant du Web.

Toujours est-il que Google dispose officiellement de 22 data centers répartis partout dans le monde et fonctionnant 24h/24 et 7j/7. Pour fonctionner en permanence, ces derniers consomment énormément d’électricité.

Selon Google, ils sont 100 % alimentés par de l’énergie verte depuis 2019. Toutefois, cela a un coût ! C’est pourquoi on peut légitimement penser que Google a tendance à favoriser les sites qui ne gaspillent pas leur budget crawl.

Mobile-First Index

Comme expliqué un peu plus haut, Google dispose de plusieurs robots chargés de crawler et d’indexer les pages internet. Il faut savoir qu’il y a un robot destiné à l’indexation desktop (ordinateur) et l’autre à l’indexation mobile.

Depuis plusieurs années déjà, c’est la version mobile qui constitue l’index principal de Google. Il s’agit du Mobile-First Index (ou MFI pour les intimes 😉 ). Ceci s’explique par le fait que la plupart des recherches web se font sur smartphone.

Pour une bonne indexation de vos pages, il est donc primordial d’avoir un site mobile friendly (dit aussi responsive), c’est-à-dire adapté pour la navigation sur téléphone.

Par ailleurs, sachez que depuis le 1er juillet 2019, tout site nouvellement mis en ligne est géré par défaut par le MFI.

2. Pourquoi l’indexation Google est importante pour moi ?

Vous vous demandez sans doute en quoi tout cela vous concerne ?

Après tout, l’indexation c’est le job de Google… Pas le vôtre.

Et pourtant ! Il est primordial de veiller à avoir un site qui facilite l’indexation, car une page non-indexée, c’est une page que les internautes ne trouveront jamais !

Sachant que plus de 90 % des internautes français utilisent Google (source), si votre site n’apparaît pas dans son index, ce sont des dizaines, voire des centaines d’opportunités qui vous passent sous le nez.

De plus, si vous aidez Google dans son travail d’indexation, il y a des chances pour qu’il vous rende la pareille avec un meilleur référencement.

Notez qu’il existe une différence notable entre indexation et référencement. L’indexation est le fait d’être connu de Google, alors que le référencement correspond au fait d’être bien classé dans les résultats de recherche.

3. Comment indexer son site sur Google ?

Soumettre un site à Google (manuellement)

Il existe plusieurs manières de faire connaître son site à Google dans l’objectif d’une indexation.

La première consiste tout simplement à lui soumettre manuellement les URL à indexer. Pour cela, il faut passer par un outil appelé Search Console. Si vous ne l’avez pas encore installé sur votre site, je vous explique comment faire juste en-dessous ⬇

Rendez-vous ensuite dans le rapport Inspection de l’URL (menu de gauche) et suivez la procédure suivante :

- Entrez l’URL de la page à indexer dans la barre de recherche de la Search Console.

- Vérifiez si la page est déjà connue de Google.

- Si Google connaît déjà cette page, assurez-vous qu’elle ne contienne aucune erreur d’indexation (sinon corrigez-la).

- Cliquez sur Demander une indexation.

C’est une opération très simple, mais qui peut être chronophage si votre site comporte un grand nombre de pages à indexer.

Maillage interne

Maillage interne et indexation : comment ça marche ?

Une autre possibilité pour permettre aux robots de découvrir facilement vos pages consiste à optimiser votre maillage interne.

Il s’agit de l’ensemble des liens cliquables présents sur votre site et qui permettent de naviguer d’une page à l’autre.

Ainsi, lorsque le crawler est sur votre page A, il pourra par exemple se rendre sur les pages B et C grâce aux liens internes. Grâce aux liens présents sur la page B, il pourra découvrir les pages D, E, F et G… et ainsi de suite.

En clair, votre maillage interne est un fil conducteur que les robots d’indexation vont pouvoir suivre.

Plus votre maillage est dense et pertinent, plus cela rend l’indexation de vos pages évidente pour les Googlebots.

Astuce pour une indexation plus rapide grâce au maillage interne

Vous l’avez sans doute remarqué, les blogs mettent souvent sur leur page d’accueil des liens internes vers leurs articles les plus récents.

Ce n’est pas pour rien.

C’est une manière d’optimiser le maillage interne pour favoriser l’indexation des nouvelles pages.

La page d’accueil est celle qui génère le plus de popularité (c’est la pierre angulaire du site, la page qui mène à toutes les autres). C’est donc généralement celle qui est crawlée le plus souvent par les robots.

En y plaçant des liens vers les pages récentes, on maximise les chances d’orienter les robots vers ces nouvelles pages et donc d’accélérer leur indexation.

Sitemap

Le sitemap : qu’est-ce que c’est et à quoi ça sert ?

Le sitemap est un fichier, traditionnellement au format XML, qui répertorie l’ensemble des URL à indexer de votre site. Ce « plan de votre site » va ensuite aider les robots à mieux parcourir les pages qui y sont indiquées.

C’est un protocole très utile si :

- votre site contient un grand nombre de pages ;

- le maillage interne n’est pas suffisamment dense pour découvrir toutes les pages ;

- aucun lien externe ne renvoie vers votre site (nous aborderons ce point en détail un peu plus loin).

En plus de vos URL, vous pouvez également indiquer d’autres informations utiles aux Googlebots comme le niveau d’importance de vos pages ou leur fréquence de mise à jour. Ces données ne sont toutefois pas obligatoires.

Par ailleurs, si vous avez un petit site et que vous ne souhaitez pas indiquer ces informations complémentaires à Google, vous pouvez tout à fait créer un sitemap au format texte (.txt). Il suffira alors d’y inscrire une URL par ligne.

Sachez aussi que si votre site utilise un flux RSS, vous pouvez l’utiliser en tant que sitemap.

Attention : un sitemap ne peut pas contenir plus de 50 000 URL. Si vous avez un site avec de très nombreuses pages, vous devrez sans doute créer plusieurs sitemaps.

Comment créer et soumettre un sitemap ?

Généralement, les CMS (Content Management System, comme WordPress par exemple) disposent d’extensions permettant de créer des sitemaps.

Le principal avantage de cette manière de procéder, c’est que la création des sitemaps est automatisée. Ainsi, un sitemap peut être généré à chaque fois qu’une modification est faite sur votre site.

Si votre CMS ne permet pas la création de sitemaps, vous pourrez passer par des outils en ligne tels que Screaming Frog ou encore XML-Sitemaps.

Enfin, la dernière méthode est de créer votre fichier manuellement. Si c’est l’option que vous retenez, voici un petit exemple.

Faisons rapidement le point sur les balises utilisées.

Les balises <urlset></urlset> délimitent les informations contenues dans le fichier, alors que <url></url> correspondent aux balises d’ouverture et de fermeture pour chaque URL.

Les balises <loc></loc> indiquent la localisation de chaque URL. Veillez à ce que chaque URL soit indiquée sous le même format (exemple : https://www.mon-site.com/). S’il manque les www. sur l’une des URL par exemple, cela ne fonctionnera pas.

L’indication <lastmod></lastmod> permet d’ajouter la date de la dernière modification au format AAAA-MM-JJ.

<changefreq></changefreq> servent à indiquer la fréquence habituelle de mise à jour de la page. Vous pouvez opter pour les options suivantes :

- always (en permanence) ;

- hourly (toutes les heures) ;

- daily (quotidiennement) ;

- weekly (toutes les semaines) ;

- monthly (tous les mois) ;

- yearly (une fois par an) ;

- never (jamais).

Les balises <priority></priority> donnent le niveau d’importance de la page par rapport aux autres. Sa valeur est comprise entre 0 (pas prioritaire) et 1 (prioritaire). Si vous optez pour une valeur décimale, utilisez un point et non une virgule (exemple : 0.7).

Une fois votre fichier correctement créé, vous devrez le placer au niveau du répertoire principal de votre site web.

Important : si la création du sitemap et son intégration sur votre serveur vous semble difficile, n’hésitez pas à confier cette tâche à votre webmaster.

Il ne vous reste plus qu’à avertir Google d’envoyer ses robots !

Pour cela, deux options s’offrent à vous. Vous pouvez soit insérer la ligne de code ci-dessous dans votre fichier robots.txt, ou passer par la Search Console.

Si vous décidez d’utiliser la Search Console, entrez tout simplement l’URL de votre sitemap dans le rapport Sitemaps et cliquez sur envoyer.

Pour plus de détails concernant les sitemaps, je vous recommande de consulter les pages d’aide de Google : À propos des sitemaps et Créer et envoyer un sitemap.

Liens depuis d’autres sites (backlinks)

Si le maillage interne peut rendre l’indexation de vos pages plus rapide, il en est de même pour les backlinks. Cela consiste à obtenir sur des sites tiers des liens pointant vers le vôtre.

L’idéal est de pouvoir placer ces liens sur des sites populaires qui bénéficient déjà de la confiance de Google. Ainsi, quand le Googlebot les visitera et verra les liens vers votre site, cela lui enverra un signal positif. En quelque sorte, la popularité de ces sites sera transmise vers le vôtre.

Les robots d’exploration comprendront que les backlinks vers votre site sont pertinents et qu’ils doivent être suivis. Vos pages seront ainsi plus facilement découvertes.

Pour que votre indexation soit encore plus rapide, essayez d’obtenir des backlinks à partir de sites qui sont régulièrement mis à jour. Ces derniers sont crawlés beaucoup plus souvent par les robots.

4. Comment savoir si mon site est indexé sur Google ?

Commande « site: »

Vous avez appliqué les bonnes pratiques d’indexation de vos pages ?

Il est temps de voir si cela a fonctionné et si votre site est connu de Google. Pour ce faire, il existe une méthode simplissime : la commande « site: ».

Il vous suffit de vous rendre sur la page de recherche de Google et de taper « site: » suivi de l’URL de votre site sans les www. Voici un exemple : site:mon-site.fr.

Si vous obtenez des résultats, cela signifie que votre site est indexé dans Google. Le moteur de recherche vous indique même le nombre (approximatif) de pages répertoriées.

Les statistiques d’exploration de Google Search Console

La commande « site: » est très bien pour vous faire une première idée de l’état d’indexation de votre site web, mais les résultats ne sont pas assez précis. Ils ne permettent pas de déterminer si vous rencontrez un problème dans l’indexation de vos pages, et lequel.

Pour déterminer cela, vous devrez passer par la Search Console. Voici comment accéder au rapport qui nous intéresse :

- Dans le menu de gauche, cliquez sur Paramètres.

- Sur la page qui s’affiche, cliquez sur Ouvrir le rapport dans l’encadré Exploration.

- Vous ouvrez alors le rapport sur les statistiques d’exploration de Google pour votre site.

Notez toutefois que si vous avez un petit site, les statistiques d’exploration ne seront pas toujours très parlantes.

Vous pouvez alors vous faire une meilleure idée de l’évolution de votre indexation. Si vous voyez une baisse inexpliquée des demandes d’exploration et qui dure, c’est peut-être qu’un problème bloque l’exploration de vos pages.

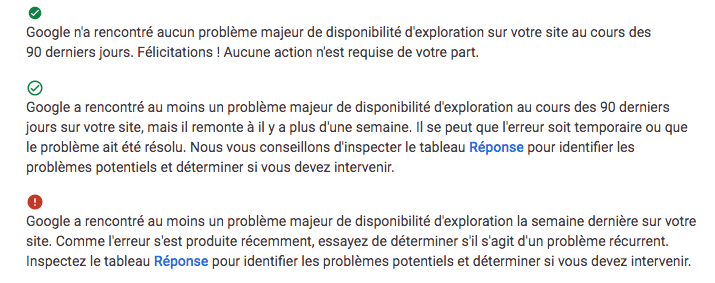

En cliquant sur l’encadré État de l’hôte, vous saurez si Google est bien en mesure de crawler votre site. L’un des 3 états suivants sera alors affiché :

Vous pouvez consulter la page d’aide de Google dédiée aux statistiques d’exploration pour connaître les problèmes les plus courants (fichier robots.txt non disponible, erreur serveur, erreur DNS, etc.) et les corrections à apporter.

5. Comment empêcher l’indexation Google ?

Pourquoi empêcher l’indexation de certaines pages ?

Après tous ces efforts pour bien indexer votre site, il peut sembler contre-intuitif de bloquer l’indexation de certaines de vos pages.

C’est pourtant une fonctionnalité utile.

Vous pourriez en avoir besoin pour :

- des raisons de confidentialité (vous ne souhaitez pas que certaines pages soient publiques) ;

- « masquer » des pages au contenu de faible qualité ou inintéressantes pour votre référencement ;

- éviter le duplicate content sur des pages au contenu similaire ou très proche ;

- etc.

En plus, cela vous aidera à préserver votre budget crawl !

Le fichier robots.txt

Comment faire pour interdire aux robots de crawler ces pages ? Tout simplement en l’inscrivant dans leur « cahier de consignes » : le fichier robots.txt.

Il s’agit d’un fichier que vous pouvez insérer à la racine de votre site et qui indique aux crawlers ce qu’ils peuvent faire ou non.

Pour leur interdire l’accès à certaines pages de votre site, vous pouvez inscrire au fichier la commande disallow suivie du répertoire concerné. Vous pouvez également spécifier si cette commande concerne tous les robots ou simplement Googlebot.

Voici le détail des lignes données dans l’exemple ci-dessus :

User-agent indique à quel robot vous donnez la consigne (ici, Googlebot). Pour que cela soit pris en compte par n’importe quel robot, remplacez Googlebot par le signe * ;

Disallow sert à signaler les répertoires à éviter de manière stricte (avec les deux //) ou étendue (avec un seul /).

Si jamais vos pages ne sont pas encore indexées, le fichier robots.txt empêchera leur crawl et, de fait, leur indexation. En revanche, si vos pages sont déjà dans l’index Google et que vous souhaitez les désindexer, c’est la balise meta robots noindex qu’il faudra utiliser en premier lieu !

En effet, si votre page est indexée et que vous mettez une balise meta robots noindex alors qu’il y a déjà un disallow dans le fichier robots.txt, le Googlebot ne pourra pas visiter la page et ne verra donc pas votre balise.

Pour résumer, le fichier robots.txt s’utilise sur les pages qui ne sont pas encore dans l’index ou déjà désindexées.

La balise meta robots noindex

Cette balise vous permet d’indiquer à Googlebot les pages à ne pas répertorier. Ici, le code s’inscrit dans le code source HTML de chaque page à désindexer.

C’est donc une bonne solution s’il n’y a que quelques pages que vous ne souhaitez pas ajouter à l’index Google.

Ajoutez la balise meta robots suivante dans l’en-tête (entre <head> et </head>) du code source de votre page :

Ainsi, lorsqu’ils arriveront sur la page en question, les robots comprendront qu’ils doivent passer leur chemin.

FAQ sur l’indexation Google

Pourquoi mon site n’est pas indexé par Google ?

Si votre site n’apparaît pas sur Google, cela peut être lié à plusieurs problèmes d’ordre technique :

- votre site est bloqué par un fichier .htaccess ;

- une erreur dans votre fichier robots.txt bloque l’indexation de tout le site ;

- vous avez placé une balise meta robots en noindex sur l’ensemble de vos pages ;

- le x-robots-tag est configuré en noindex.

Il peut aussi s’agir d’une désindexation requise par Google suite :

- au piratage de votre site : ce dernier n’est pas sûr pour vos visiteurs ;

- à une pénalité manuelle.

Pour en savoir davantage sur les facteurs techniques qui bloquent votre indexation ou sur la désindexation à l’initiative de Google, je vous conseille de consulter cet article : Mon site n’apparaît pas sur Google | 7+1 causes possibles

Vous pouvez aussi vous rendre dans le rapport Couverture de la Search Console pour vérifier si Google a rencontré d’éventuels problèmes d’exploration. Il vous suffit de sélectionner l’encadré Erreur.

Parfois, cela n’est pas un problème d’indexation, mais de référencement. Cela signifie que le SEO de votre site n’est pas suffisamment bon pour le faire remonter dans les résultats de Google.

Dans ce cas, des actions d’optimisation s’imposent !

Si vous pensez être dans cette situation, je vous invite à regarder cette vidéo et à vous inscrire à ma MasterClass SEO gratuite.

Que veut dire « explorée, actuellement non indexée » dans Search Console ?

Lorsque vous vérifiez les pages exclues de l’index Google sur la Search Console, certaines peuvent avoir la mention « explorée, actuellement non indexée ».

Cela signifie que le Googlebot a réussi à crawler ces pages. Il en a repéré le contenu. Toutefois, il ne les a volontairement pas ajoutées à l’index.

Pensez à vérifier de temps à autre ces pages exclues de l’index pour vérifier si Google a eu raison de les ignorer ou non.

Combien de temps prend l’indexation Google ?

Tout dépendra de la méthode d’indexation utilisée.

Pour vous donner un ordre d’idée, une demande d’indexation manuelle peut prendre de quelques minutes à 48 heures.

Pour les autres méthodes, il faudra attendre que les robots découvrent vos pages par eux-mêmes, ce qui est généralement un peu plus long (de quelques jours à quelques semaines).

Rappelez-vous que votre site internet peut être indexé rapidement, mais son bon positionnement dans Google sera plus long.

Lorsque vous ne trouvez pas votre site sur Google, pensez toujours à utiliser la commande « site: ». Cela vous permettra de distinguer un souci d’indexation d’un problème de référencement (positionnement).

Si aucun résultat ne ressort, c’est votre indexation qui pose problème. La solution à votre souci se trouvera alors certainement dans l’article que vous venez de lire 😉

Si vous obtenez des résultats, ce n’est pas votre indexation qu’il faudra travailler, mais votre SEO !

Pour cela, n’hésitez pas à télécharger gratuitement mon livre blanc qui vous aidera à remonter dans les premiers résultats de Google.

Passionné d’e-commerce et de SEO, je suis le créateur du site reussir-mon-ecommerce.fr. Depuis plus de 15 années, j’aide les e-commerçants à développer sainement leur entreprise. Et si je ne suis pas devant mon écran, c’est que je suis derrière ma batterie à jouer du rock ! !